A&T – Automation & Testing 18° Edizione Febbraio 2024 – TO

16/02/2024 12:15-13:00 Cod. TR2414 Sala AREA CONFERENZE 3

Nota introduttiva di G. ZURLO

In vista del ciclo di conferenze tenute dall’Ing. Balsamo di INRIM che si stanno organizzando in ambito CDT ho pensato che sarebbe stata utile una “News CDT” in cui riportare i contenuti essenziali della Tavola Rotonda tenuta dai relatori INRIM sotto elencati e a cui ho assistito durante la visita alla Fiera dedicata a Innovazione, Tecnologie, Affidabilità e Competenze

.

.

.

Presente e futuro delle attività INRiM in ambito AI

Negli ultimi anni l’applicazione dell’Intelligenza Artificiale (AI) ha aperto nuovi orizzonti nei settori della metrologia, contribuendo significativamente agli ambiti dello spazio, della medicina, e dell’informazione quantistica. Questa convergenza tra AI e metrologia, insieme alla crescente digitalizzazione, sta delineando il futuro delle misurazioni di precisione, delle reti di sensori e più in generale dei processi scientifici avanzati.

Con l’aiuto dei ricercatori INRiM verrà presentato lo stato dell’arte attuale e gli obiettivi futuri delle attività in ambito AI coordinate dall’Istituto Nazionale di Ricerca Metrologica.

Modera:

Giovanni Durando

- Machine Learning per il rilevamento di anomalie su orologi atomici in Sistemi di Navigazione Satellitare

Ilaria Sesia - Applicazione sinergica dell’intelligenza artificiale e della metrologia nella diagnostica per immagini

Alessandra Manzin - Serie temporali e AI: analisi dati, correzioni e previsioni

Gianfranco Durin - Metrologia per le tecnologie quantistiche

Ivo Pietro Degiovanni

.

.

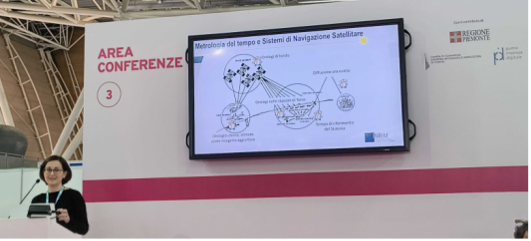

- La prima relazione è stata tenuta da Ilaria Sesia, della Divisione “QN Metrologia quantistica e nanotecnologie” – Settore “QN 05 Tempo e frequenza”, su un tema piuttosto specialistico di Machine Learning(sottoinsieme dell’AI relativo a Sistemi Informatici che apprendono dall’esperienza In cosa consiste il Machine Learning? | Oracle Italia) ossia come si possono rilevare e gestire le anomalie degli orologi atomici utilizzati ad es. nei Sistemi di Navigazione Satellitare.

Tutti gli orologi devono essere sincronizzati sia fra di loro che con quelli a terra per ottenere una buona precisione del posizionamento nei sistemi di navigazione, come anche per l’ora esatta, e per questo motivo l’INRiM è coinvolta da circa 20 anni con il gruppo della relatrice nello sviluppo del Sistema di Posizionamento Galileo in collaborazione con l’Agenzia Spaziale Europea (ESA) per la valutazione delle prestazione degli orologi del Sistema stesso.

Tutti gli orologi devono essere sincronizzati sia fra di loro che con quelli a terra per ottenere una buona precisione del posizionamento nei sistemi di navigazione, come anche per l’ora esatta, e per questo motivo l’INRiM è coinvolta da circa 20 anni con il gruppo della relatrice nello sviluppo del Sistema di Posizionamento Galileo in collaborazione con l’Agenzia Spaziale Europea (ESA) per la valutazione delle prestazione degli orologi del Sistema stesso.

NOTA: Galileo – GNSS – Global Navigation Satellite System – è stato sviluppato in Europa come alternativa al GPS – Global Positioning System – controllato dal Dipartimento della Difesa USA.

Per capire di che ordini di grandezza si sta parlando basta considerare che un errore di un milionesimo di secondo nella sincronizzaione degli orologi si traduce in un errore di trecento metri nella posizione mentre un errore di un secondo significa trecentomila km di differenza! (s = c x t dove c è la velocità della luce).

Gli errori degli orologi atomici sono contenuti nell’ordine del miliardesimo di secondo, equivalenti a uno scarto di una trentina di cm fra la posizione effettiva e quella determinata dal sistema di rilevamento.

Il ruolo dell’INRiM consiste essenzialmente nel valutare lo “stato di salute” degli orologi utilizzati determinando se, quando e come devono essere ripristinati o sostituiti.

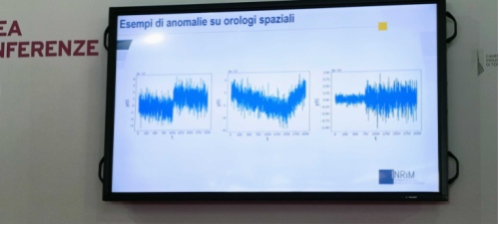

Il comportamento di un orologio atomico è un mix fra quello deterministico, descrivibile con equazioni classiche che lo correlano con i fattori d’influenza, e quello stocastico, derivante cioè in modo casuale da fattori di disturbo classificabili come “rumore”.

Possono manifestarsi anomalie di diverso tipo (vedi l’immagine sotto riportata) come salti o cambiamenti di pendenza della frequenza oppure incremento improvviso del rumore

Le anomalie possono dipendere da parametri locali, ad es. la temperatura, oppure da cause molto lontane come le radiazioni provenienti da una tempesta solare, e devono essere strettamente monitorate per informare il gestore del sistema che dovrà adottare delle contromisure idonee ad evitare errori significativi da parte degli utilizzatori (tipicamente disattivare temporaneamente gli orologi coinvolti dall’anomalia).

Le anomalie possono dipendere da parametri locali, ad es. la temperatura, oppure da cause molto lontane come le radiazioni provenienti da una tempesta solare, e devono essere strettamente monitorate per informare il gestore del sistema che dovrà adottare delle contromisure idonee ad evitare errori significativi da parte degli utilizzatori (tipicamente disattivare temporaneamente gli orologi coinvolti dall’anomalia).

L’INRiM, in collaborazione con POLI-TO, ha sviluppato da una quindicina di anni dei metodi di monitoraggio particolarmente efficaci che rilevano svariati parametri dell’ambiente in cui sono gli orologi atomici e li trasmettono a terra per istituire correlazioni con le anomalie prima illustrate. C’è una enorme mole di dati relativa ai circa 25 satelliti del sistema Galileo rilevati per circa 15 anni e per analizzarli si fa uso dei sistemi di Machine Learning che si sono evoluti negli ultimi anni.

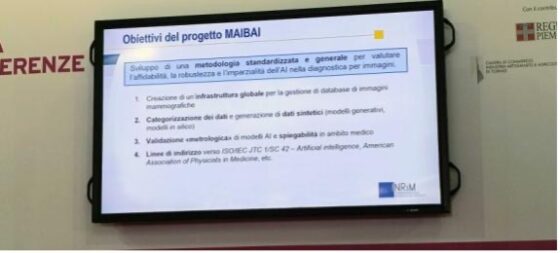

- È seguita una relazione di Alessandra Manzin, della Divisione “ML Metrologia dei materiali innovativi e scienze della vita” – Settore “ML 04 Scienze e tecnologie biomediche”, sull’applicazione dell’AI nell’indagine sulle immagini, in particolare quelle della mammografia.

L’incremento dei dati in ambito medico e il progresso nelle tecnologie digitali ha spinto la ricerca scientifica verso lo sviluppo di nuovi sistemi diagnostici e predittivi basati sull’AI. Nel congresso Oncology del 2020 sono state presentate svariate mammografie con lesioni cancerose identificate dall’AI, ma non dai radiologi! Esistono comunque delle criticità correlate ad es. con la protezione dei dati in quanto particolarmente sensibili, con la loro grande eterogeneità e con l’attuale assenza di robuste procedure di validazione. Attualmente non siamo ancora ad un livello soddisfacente di attendibilità dei risultati ottenuti con l’utilizzo dell’AI, ma ci si sta muovendo in questa direzione.

L’incremento dei dati in ambito medico e il progresso nelle tecnologie digitali ha spinto la ricerca scientifica verso lo sviluppo di nuovi sistemi diagnostici e predittivi basati sull’AI. Nel congresso Oncology del 2020 sono state presentate svariate mammografie con lesioni cancerose identificate dall’AI, ma non dai radiologi! Esistono comunque delle criticità correlate ad es. con la protezione dei dati in quanto particolarmente sensibili, con la loro grande eterogeneità e con l’attuale assenza di robuste procedure di validazione. Attualmente non siamo ancora ad un livello soddisfacente di attendibilità dei risultati ottenuti con l’utilizzo dell’AI, ma ci si sta muovendo in questa direzione.

In questo contesto s’inserisce il progetto di ricerca europeo MAIBAI partito nel settembre 2023 e coordinato dall’INRiM

i cui obiettivi sono elencati nell’immagine sottostante

L’obiettivo principale del progetto è lo sviluppo di una strategia globale standardizzata che consenta di validare modelli di AI nell’indagine di immagini mammografiche.

L’obiettivo principale del progetto è lo sviluppo di una strategia globale standardizzata che consenta di validare modelli di AI nell’indagine di immagini mammografiche.

Un articolo recentemente pubblicato sul Wall Street Journal sottolinea come i medici dovranno imparare dai ricercatori come utilizzare questi strumenti in ambito clinico per arrivare al concetto di “realtà aumentata” e servirsene a fini diagnostici e predittivi.

- È stata la volta del terzo relatore, Gianfranco Durin, della Divisione “ML Metrologia dei materiali innovativi e scienze della vita” – Settore “ML 05 Magnetismo, materiali e spintronica” con un intervento focalizzato anch’esso come il 1° sulle serie temporali, ma in un contesto completamente diverso: il mare invece dello spazio.

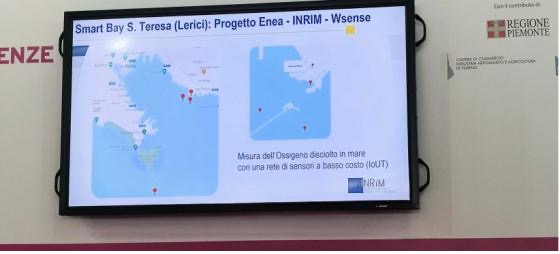

È stato illustrato il progetto Enea – INRiM – Wsense per la misura dell’ossigeno disciolto nella baia di Lerici in una zona dove ci sono allevamenti di mitili e affini perché è un parametro critico per la produttività dell’allevamento.

L’obiettivo è di avere una elevata attendibilità dei dati utilizzando una rete di sensori che siano resistenti all’ambiente marino in cui sono immersi e con una elevata potenza di trasmissione dei dati che in acqua tendono a disperdersi facilmente.

L’obiettivo è di avere una elevata attendibilità dei dati utilizzando una rete di sensori che siano resistenti all’ambiente marino in cui sono immersi e con una elevata potenza di trasmissione dei dati che in acqua tendono a disperdersi facilmente.

Il supporto dell’INRiM riguarda diversi aspetti: in primis, la “pulizia” dei dati (vedi immagine sottostante)

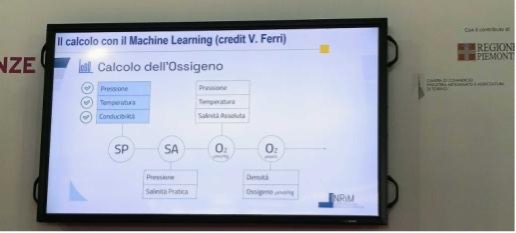

In seconda battuta, la gestione con le tecniche di “Machine Learning” dei molti fattori che determinano la % di ossigeno disciolto in una determinata zona marina

In seconda battuta, la gestione con le tecniche di “Machine Learning” dei molti fattori che determinano la % di ossigeno disciolto in una determinata zona marina

Un importante fattore di criticità è il vincolo che, essendo necessari numerosi sensori, questi devono essere a basso costo e sono quindi soggetti ad un elevato rumore di fondo che “sporca” il segnale rendendo indispensabile l’uso del Machine Learning per “pulirlo”.

Un importante fattore di criticità è il vincolo che, essendo necessari numerosi sensori, questi devono essere a basso costo e sono quindi soggetti ad un elevato rumore di fondo che “sporca” il segnale rendendo indispensabile l’uso del Machine Learning per “pulirlo”.

Last but not least, gli animali marini di tipo “stazionario” si attaccano a qualunque cosa stia ferma e quindi dopo poco tempo i sensori sono “infestati” dal plancton che gli si è attaccato.

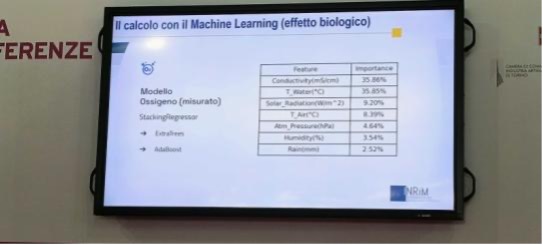

I due fattori dominanti (vedi slide sottostante) si sono rivelati essere la conducibilità e la temperatura dell’acqua che da soli influiscono per oltre il 70% del totale dei sei fattori di incidenza indivduati

Nota a margine: il che conferma la validità statistica del Principio di Pareto: in questo caso il 30% delle cause incide sul 70% degli effetti…

L’utilità pratica di questa tecnica consiste nel consentire di ricostruire con elevata attendibilità il segnale anche nei transitori in cui per un qualche motivo si attenuava o spariva!

L’utilità pratica di questa tecnica consiste nel consentire di ricostruire con elevata attendibilità il segnale anche nei transitori in cui per un qualche motivo si attenuava o spariva!

Con l’aiuto dell’AI sono stati quindi individuati i fattori principali che determinano la % di ossigeno disciolta con i relativi pesi di incidenza, cosa assolutamente fondamentale per migliorare l’attendibilità delle osservazioni e delle previsioni sul trend temporale della caratteristica in questione.

- L’ultimo relatore è stato Ivo Pietro Degiovanni, della Divisione “QN Metrologia quantistica e nanotecnologie” – Settore “QN 04 Ottica quantistica e fotometria” che ha presentato alcune connessioni esistenti fra metrologia e tecnologie quantistiche, tema di non semplice comprensione in quanto fa riferimento a caratteristiche del mondo atomico molto lontane dalle esperienze quotidiane e per certi aspetti assolutamente contro-intuitive

Nota a margine: Feynman ebbe a dire una volta “Nessuno, me compreso, capisce la meccanica quantistica” intendendo dire che certi comportamenti delle particelle subatomiche sono talmente “strani” da risultare incomprensibili perfino ai fisici di professione.

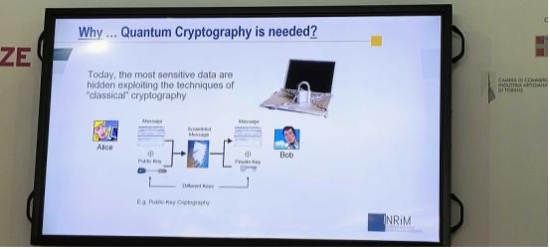

L’argomento è stato sempre nell’ambito dell’ Information Technology, ma correlato non tanto con l’AI quanto con l’informazione quantistica. Il motivo per cui l’argomento sta uscendo dai laboratori di ricerca ed entrando nel mondo quotidiano è collegato con la sicurezza dei dati sia nella loro trasmissione che nello storage. Attualmente la crittografia più diffusa è quella asimmetrica, o “a chiave pubblica”, che si basa sulla facilità di calcolare il prodotto di numeri primi anche molto grandi, ma sulla contemporanea difficoltà di individuare in quali numeri primi può essere scomposto (ossia “fattorizzato”) un numero intero enormemente grande (per qualunque numero intero vale il teorema dell’unicità della sua scomposizione in numeri primi)

L’argomento è stato sempre nell’ambito dell’ Information Technology, ma correlato non tanto con l’AI quanto con l’informazione quantistica. Il motivo per cui l’argomento sta uscendo dai laboratori di ricerca ed entrando nel mondo quotidiano è collegato con la sicurezza dei dati sia nella loro trasmissione che nello storage. Attualmente la crittografia più diffusa è quella asimmetrica, o “a chiave pubblica”, che si basa sulla facilità di calcolare il prodotto di numeri primi anche molto grandi, ma sulla contemporanea difficoltà di individuare in quali numeri primi può essere scomposto (ossia “fattorizzato”) un numero intero enormemente grande (per qualunque numero intero vale il teorema dell’unicità della sua scomposizione in numeri primi)

Nota a margine: Per quanto possa sembrare strano, per moltiplicare fra di loro 2 numeri primi di 100 cifre ciascuno basta un normale computer che fa il calcolo in molto meno di un secondo, mentre, dato il numero che risulta dal loro prodotto, ma non i numeri primi che lo compongono, anche il computer più potente oggi esistente impiegherebbe un tempo enorme, stimabile in parecchi anni, per determinarli.

Fattorizzare un intero molto grande fa parte dei cosiddetti problemi “NP” (Non Polinomiali) o anche “non facilmente risolvibili da un computer” ed è questa caratteristica che viene sfruttata per proteggere i dati da intrusioni non autorizzate.

Fattorizzare un intero molto grande fa parte dei cosiddetti problemi “NP” (Non Polinomiali) o anche “non facilmente risolvibili da un computer” ed è questa caratteristica che viene sfruttata per proteggere i dati da intrusioni non autorizzate.

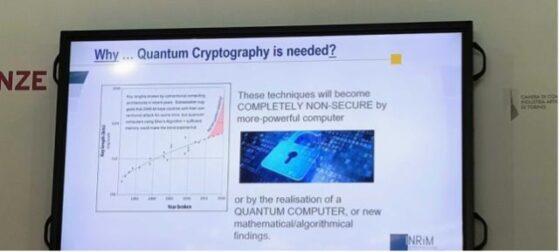

Il fatto è che con l’aumentare della potenza computazionale (computer sempre più veloci e in grado di trattare grandi quantità di dati) la stringa numerica della chiave pubblica deve essere sempre più lunga per non essere decrittabile come conseguenza della “legge di Moore” che implica il raddoppio della capacità di calcolo ogni non molti anni, cioè in crescita esponenziale.

Il “salto di qualità” sulla decrittazione fu fatto nel 1994 quando un informatico dell’IBM inventò un algoritmo che in linea di principio può essere utilizzato per fare funzionare un computer quantistico, che si basa cioè sulla meccanica quantistica, concretizzando la previsione di Feynman di una decina di anni prima che un computer quantistico possa risolvere anche problemi di tipo NP, compresa la fattorizzazione di numeri interi enormemente grandi, vanificando così la sicurezza dei dati basata sulla crittografia asimmetrica (facile moltiplicare fra di loro numeri primi, difficile scomporre un numero intero in numeri primi).

A che punto siamo con il computer quantistico? Ancora non c’è, ma diversi “colossi” privati (Google, IBM e altri) stanno investendo milioni e milioni di dollari per cercare di realizzarlo e sul sito dell’NSA (vedi slide sottostante) già nell’agosto del 2015 c’era scritto che bisogna pianificare la transizione verso algoritmi che resistano alla decrittazione quantistica.

La soluzione al problema c’è: si chiama “distribuzione quantistica di chiavi crittografiche” e si basa sul principio di indeterminazione di Heisenberg (che, in forma semplificata, asserisce che non è possibile azzerare simultaneamente l’incertezza nella determinazione dei valori di due variabili coniugate di una particella quali ad es. posizione / impulso, energia / tempo, etc.) che rende potenzialmente indecrittabili le chiavi e quindi sicuro il sistema di protezione dei dati anche verso i computer quantistici.

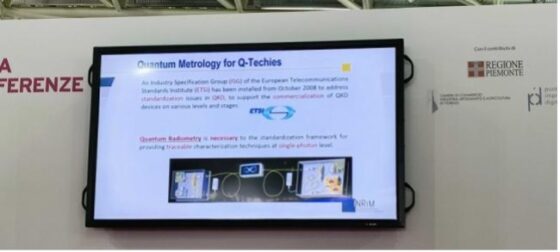

L’INRiM c’entra in tutto questo perché ha una sezione che sviluppa gli aspetti metrologici delle tecnologie quantistiche di cui quello della protezione dei dati è solo un aspetto, come la radiometria quantistica (vedi slide sottostante)

È attivo anche nella standardizzazione delle tecnologie quantistiche e partecipa al progetto europeo ETSI per la standardizzazione delle chiavi quantistiche allo scopo di aumentare la sicurezza dei dati.

G.Z.

TO 21/02/2024

La Presidenza del Club CDT ringrazia il proprio Socio Consigliere, l’ing. Giovanni Zurlo per il tempo dedicato all’ascolto dell’evento e per il racconto che ne ha fatto a beneficio dei Soci CDT, in attesa del ciclo di eventi che abbiamo organizzato, che prevede anche una Visita ai Laboratori INRIM.